Autant de questions qui ont une réponse et une réalité ténébreuse qui persiste de nos jours comme une grande main noire qui s’étend même dans les racines les plus profondes d’une société qui se tait et consent.

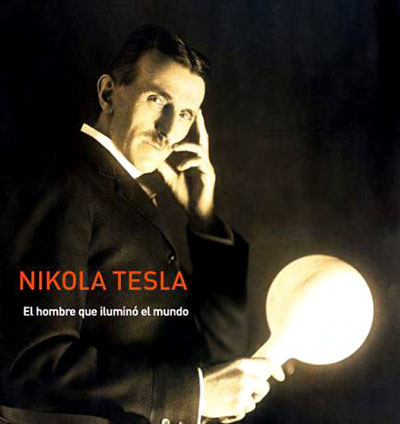

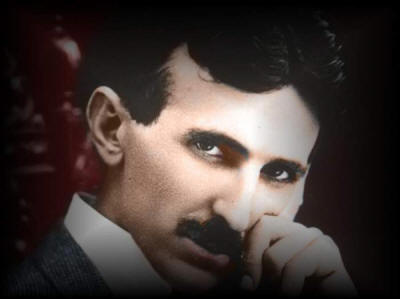

Nikola se félicitait avant tout que ses inventions aideraient l’humanité plutôt que d’avoir un prix ou une reconnaissance, même économique; de sorte qu’à son époque, beaucoup moins aujourd’hui, aucun scientifique ou inventeurs ne serait disposés à offrir à la société.

Son cœur était aussi grand que son intelligence et ses inventions, dont beaucoup ont été oubliés par la pauvreté dans laquelle il a vécu sa dernière étape de la vie.

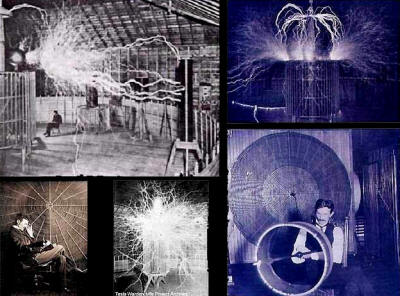

Tesla était fasciné par l’énergie rayonnante et son potentiel à devenir de l’énergie libre. Il savait qu’il était possible d’exploiter l’énergie directement par “connexion à la véritable force de la nature.”

Pendant queques temps, Tesla a travaillé avec Edison et il l’admirait. Mais Edison ne le respectait pas, il le fit travailler 18 heures par jour, sept jours par semaine afin de résoudre les problèmes techniques qu’il avait.

Quand Tesla est décédé, ses grandes inventions des 10 dernières années ont été oubliées, et volontairement, on a fait en sorte qu’il soit connu pour son excentricité.

À sa mort, l’histoire manipulée tentée d’effacer son empreinte et d’exalter des hommes comme Edison qui a été proclamé comme étant le père de l’énergie et qui a rejoint sans hésitation les critiques contre Tesla en dépit que sans lui, Edison n’aurait été personne.

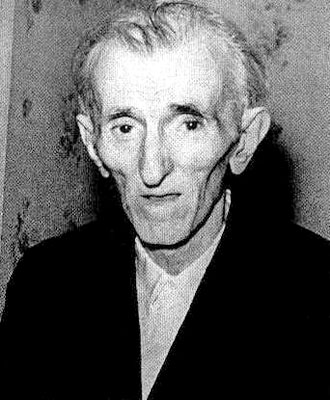

Tesla est mort seul, oublié, abandonné, comme tous les grands savants de l’histoire dans sa chambre d’hôtel à 86 ans. Il a été retrouvé par une femme de ménage le jour suivant.

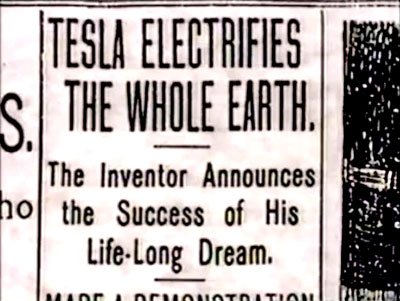

Aujourd’hui, tout son travail est toujours sous secret d’État.

Le gouvernement invisible qui est derrière le réel dirige la société et la soumet à ces caprices. Ils ont réalisé un travail gigantesque sur Nikola Tesla, en l’effaçant de l’histoire, en prenant soin qu’il soit vu comme un excentrique et un fou, l’amenant à la ruine et la mort dans l’oubli.

Ceci est son histoire, son héritage, sa vie, sa réalité et il a été coulé pour vouloir offrir au monde un niveau de vie dont il ne jouit pas aujourd’hui.

Nous devons le sortir de l’oubli, le mettre sur un piédestal puis exiger que ses découvertes cessent d’être séquestrées et qu’ils se mettent au service du progrès mondial.

Les Armes Electromagnétiques Scalaires Soviétiques

Ce dossier présente les concepts de bases des armes électromagnétiques scalaires soviétiques, parmi les principaux types disponibles, ainsi que les preuves et les indices de leur utilisation largement répandue.

L'Electromagnétisme scalaire, c'est l'Electrogravitation

L'électromagnétisme scalaire est une extension de l'électromagnétisme (EM) actuelle qui inclut la gravitation. C'est une électrogravitation unifiée, et, ce qui est plus important, c'est une théorie unifiée. Ses bases ont été découvertes par Nikola Tesla.

Dans l'extension EM scalaire, l'énergie du champ EM peut être transformée en énergie de champ gravitationnel et vice et versa. Cette transformation peut être structurée et localisée, dans des zones ou objets spécifiques. Un tel passage contrôlé de l'électromagnétisme à la gravitation n'est pas possible dans l'EM normal ou la physique actuellement enseignée dans les manuels occidentaux. Cependant des fragments et morceaux de cette théorie ont été éparpillés à travers la littérature de physique depuis quelques temps, mais aucun scientifique orthodoxe de l'Ouest ne semble avoir réalisé que ces portions anormales pouvaient être intégrées en une nouvelle physique étonnante. Des expérimentateurs non-orthodoxes, des inventeurs, et des scientifiques ont réalisés des découvertes dans cette arène depuis plusieurs décades, mais de nouveau personne n'a réalisé les implications exactes ou la manière précise dans laquelle leurs résultats pouvaient être combinés avec la physique électrique actuelle.

Fer-De-Lance

Une telle léthargie n'est certainement pas présente en Union Soviétique. Depuis au moins trois décennies, l'Union Soviétique a développé l'électrogravitation et l'a appliquée pour développer d'étranges nouvelles armes secrètes d'une capacité et d'une puissance incroyable. Ils ont poursuivi le plus grand programme de développement d'armes jamais lancé par aucune nation et, de manière efficace, ils l'ont tenu caché des yeux occidentaux indiscrets. J'ai appelé ce programme "Fer-De-Lance", d'après le serpent mortel d'Amérique du Sud du même nom.

Le redouté fer-de-lance est un serpent d'une grande agilité dont l'effet de la morsure est létale. Il dresse souvent une embuscade à sa proie infortunée, et frappe à l'improviste sans prévenir. Sa première frappe soudaine est habituellement mortelle à sa victime qui expire rapidement en se tordant de convulsions dans son agonie. Puisque le développement soviétique d'armes scalaires électromagnétiques a été prévu pour le même but, le nom semble approprié.

Un effort équivalent à environ sept projets Manhattan a été placé dans Fer-De-Lance par les soviétiques, et le programme a réussi presque au-delà de l'imagination. Les sinistres armes sont maintenant développées, déployées, et testées. L'embûche est complète ; Fer-De-Lance est enroulé et prêt à frapper.

Les armes "énergétiques" et "à énergie dirigée (DEWs)"

Le nom soviétique ordinaire pour ce type de science de l'armement est, "énergétiques". A l'Ouest ce terme est habituellement associé aux armes à énergie dirigée conventionnelle (DEW) [Directed Energy Weapons] comme les armes à faisceaux de particules, lasers, systèmes d'énergie dirigée en radio-fréquences (RF), etc. Les Soviétiques ne limitent pas le terme de cette façon.

Les scientifiques occidentaux se sont uniquement familiarisés avec les armes à énergie dirigée où, des fragments, des masses, des photons, ou des particules, parcourent l'espace et entrent en contact avec la cible pour délivrer leurs effets. A partir de là, dans leur pensée, ils limitent le terme soviétique "énergétiques" aux types d'armes qu'eux mêmes comprennent -- armes exotiques mais normales c'est-à-dire utilisant une énergie ou une masse traversant l'espace et allant impacter une cible.

Cependant il est possible de focaliser un potentiel afin que les effets d'une arme aillent au travers de l'espace-temps lui-même, de manière que masses et énergies "ne parcourent pas l'espace" entre l'émetteur et la cible. Au lieu de cela, les ondulations et les structures dans la fabrique de l'espace-temps lui-même sont manipulées pour se rencontrer et interférer à, et dans, l'espace temps local depuis une quelconque distance de la cible. Là, l'interférence de ces structures ondulatoires crée l'effet énergétique désiré (d'où le terme "énergétiques") dans et à travers la cible elle-même, émergeant de l'espace-temps (du vide) dans lequel la cible est incorporée dans le lieu où elle se trouve à distance. "Énergétiques", comme les soviétiques l'utilise, se réfère à ces sinistres nouvelles armes, ainsi qu'aux plus banales DEW connues à l'ouest.

En conséquence de la découverte soviétique et de décennies de développement fébrile, des armes stratégiques monstrueuses insoupçonnées à l'ouest sont déjà dans les mains des Soviétiques. Un nœud coulant est lentement et fermement resserré sur nos gorges, et il est déjà la onzième heure.

Les Soviétiques ont planifié une supercherie.

Parallèlement à ce programme de développement super-secret, les Soviétiques ont développé et mis en oeuvre un plan de mystification pour dissimuler ces armes étonnantes, ainsi que leur nature, des regards occidentaux jusqu'à ce qu'il soit trop tard. La mystification soviétique a si bien réussie que même lorsque les scientifiques occidentaux sont confrontés avec les tests réels de ces armes directement au dessus de leurs têtes, ils n'identifient pas l'arme de guerre ni la nature des effets produits.

Dès le début de janvier 1960, Nikita Khrouchtchev a annoncé le développement en Union Soviétique d'une nouvelle arme fantastique.

Le 10 avril 1963 l'une des premières nouvelles superarmes déployées opérationnellement a été utilisée pour détruire le sous-marin atomique U.S.S. Thresher en plongée, au large de la côte est des États-Unis. Le jour suivant, le 11 avril 1963, la même superarme déployée a été utilisée dans un mode différent pour produire une explosion sous-marine géante dans l'océan sur la Fosse de Porto Rico à 160 kilomètres au nord de Porto Rico.

Au fil des années, différents avions ont subi des interférences ou ont été descendus par les essais de ces armes soviétiques. Un cas particulier concernait la perte mystérieuse de plusieurs F-111 dans le conflit du Vietnam. Au moins un équipage de F-111 descendu a été récupéré dans les échanges de prisonniers de guerre qui ont suivi. Sur cet avion tous les systèmes électriques se sont trouvés en difficulté simultanément. Cela était probablement dû aux équipes soviétiques spéciales convertissant des systèmes radars de missile nord-vietnamien SA-2 au mode EM scalaire, et employant une interférence de "faisceau scalaire" pour produire des bruits EM parasites dans les systèmes électriques et électroniques de l'avion.

En fin avril/début mai 1985, l'armada entière des superarmes EM scalaires stratégiques soviétiques a été activée lors d'une célébration spéciale du 40ième anniversaire de la fin de la seconde guerre mondiale. L'activation de cette armada (qui comprenait probablement plus de 100 armes géantes), couplée à 27 générateurs géants et un grand nombre de commandes et de contrôles de transmissions, ont été surveillés sur un système de détection avancée appartenant à Frank Golden. Après le gigantesque exercice stratégique, qui a duré plusieurs jours, la plupart des armes et des sources d'énergie ont été désactivées pour se tenir prête à l'action.

Les lancements de la navette de la NASA ont fourni une opportunité de choix pour les tests soviétiques de ces superarmes en mode ABM dans la phase de lancement, là où un missile lancé peut être détecté et détruit peu de temps après le décollage [NDT : ABM pour anti-missile balistique]. Au début, les explosions de la pulsation électromagnétique (EMP) sur la trajectoire que la navette venait d'emprunter, ont été délibérément décalées dans le temps, pour empêcher en fait la destruction de la cible et éviter d'alerter les U.S.A. que quelque chose d'inhabituel était en train de se passer.

Le tir de navette du 26 novembre 1985 a vu un test particulièrement significatif dans ce domaine. Dans ce cas, une très forte explosion ou "boum sonique" a eu lieu sur le site de lancement 12 minutes après le décollage de la navette, tandis que la navette était déjà au loin sur sa trajectoire prévue. Au moins deux lancements précédents de la navette avaient été utilisés comme pseudo-cibles, avec sur le pas de tir des boums décalés dans le temps qui retentissaient bien en arrière des véhicules.

Après que l'absence de réaction américaine à ces tests ait montré que les U.S.A. n'avaient encore aucune connaissances de cette nouvelle technologie et n'identifiaient même pas son emploi, les soviétiques ont apparemment décidés d'effectuer des tests où la cible serait réellement détruite.

Le 12 décembre 1985 la même arme soviétique testée contre les lancements de la navette de la NASA a délibérément interféré avec les contrôles d'un DC-8 Arrow décollant de la base Gander Air Force à Newfoundland. A une altitude de 30 mètres, l'avion transportant plus de 250 soldats américains et les membres de l'équipage civil, a perdu sa puissance et s'est écrasé au sol, tuant tout le monde à bord. Trois Canadiens témoins du crash ont été interviewés aux informations télévisées de la Canadian Broadcast Corporation le 8 avril 1986 à 22 heures. Aucune flamme ou fumée n'est sortie de l'avion avant sa chute et son crash. Cependant l'avion a été vu mystérieusement illuminé d'une lueur jaune. Cela est la signature d'un obusier scalaire dans le mode "émergence EM continue", similaire à la manière dans laquelle les F-111 ont été descendus au Vietnam. En résumé, les systèmes électriques du DC-8 ont subi une interférence avec un bruit électromagnétique créé à travers l'espace-temps occupé par l'avion. La charge puissante créée dans et autour de l'avion a aussi causé apparemment la perte des deux moteurs, l'un après l'autre. Avec ses contrôles inopérants et sa puissance considérablement réduite, l'avion est retombé au sol, encore dans sa configuration de décollage "nez en l'air, queue en bas", et s'est crashé et a brûlé. La "lueur jaune" était un halo électrique dû à l'acquisition d'une haute charge électrique par la paroi de l'appareil.

D'autres facteurs ont pu contribuer au crash en perturbant le décollage, la faiblesse de la maintenance des moteurs, le poids accru de l'avion dû à la glace et à la forte charge. Jusqu'à présent personne n'a identifié la "lueur jaune" ou ce qu'elle implique, ou la possible connexion entre la perte de l'avion et le test soviétique précédent d'un système ABM en Phase de Lancement contre les tirs de navette américaines...

En septembre 1987, les deux derniers missiles Titan 34-D de l'Air Force mis à feux à la base de Vandenburg Air Force en Californie se sont désintégrés peu après le lancement. Le premier s'est désintégré le 28 août 1985 juste après le décollage. Cette perte a été attribuée a une panne d'une pompe de carburant haute puissance, provoquant une fuite massive de comburant et une fuite moindre de carburant. La seconde perte de Titan a eu lieu le 18 avril 1986 quand le missile s'est désintégré 5 secondes après le décollage. Son échec est encore sous investigation et aucune cause n'a été déterminée. Apparemment la navette et le Titan sont actuellement les seuls lanceurs viables pour le lancement des satellites américains "spy". La perte de ces satellites sensitifs -- si vraiment ils constituaient les charges utiles -- n'aide pas mais peut être dommageable à notre capacité stratégique. Selon le Los Angeles Times (en 1986) l'unique rescapé, le satellite KH-11 a été lancé en décembre 1984 et, avec une espérance de vie de deux à trois ans, pourrait arrêter de fonctionner à la fin de cette année.

Pour le moment nous ne savons pas s'il a existé ou non une activité significative de la grille/réseau "Pivert" dans le voisinage du lancement du Titan en août 1985. Cependant, une activité significative a eu lieu manifestement dans le réseau avant le désastre du Titan du 18 avril et le jour même.

Le dimanche de Pâques 30 mars 1986, l'ingénieur Ron Cole a observé une interférence significative qui corrélait avec les mesures du Pivert soviétique. Le 18 avril, T.E. Bearden, peut-être le chef de recherche SEM aujourd'hui, a observé des traces d'un nuage radial sur Huntsville en Alabama et en a pris des photographies. Des rapports préliminaires de Thousand Oaks en Californie indique à nouveau une activité importante du réseau le 18 avril, le jour où le second Titan a explosé.

La seconde au moins de ces deux destructions de missiles peu après le décollage est suspicieuse, puisque le réseau était positivement actif à ce moment là. Il y a également une preuve claire de l'existence de systèmes ABM en Phase de Lancement, depuis le grand exercice scalaire d'avril/mai 1985. Donc la première explosion de Titan en août 1985 tombe dans la période soviétique "maintenant testons les contre les lanceurs américains". La perte du second Titan suit les pertes hautement suspicieuses du DC-8 Arrow du 12 décembre et de Challenger du 28 janvier 1986. La même arme soviétique qui a détruit ces cibles peut aussi avoir détruit l'un ou les deux Titans incriminés.

Les Soviétiques furent capables également de manipuler significativement le climat sur l'Amérique du Nord depuis plus de dix ans sans être découvert. Ils ont testé une gamme fantastique d'armes de défense anti-missiles balistiques (ABM) depuis plus de deux décennies, et personne n'est plus avisé dans l'Ouest.

Comme cela a été dit précédemment, avant la fin novembre 1985, au moins trois essais "tirs à blanc" soviétique d'un "système ABM en phase de lancement" contre les lancements réels de la navette américaine avaient été effectués directement sur Cap Canaveral lui-même et personne encore n'avait identifié ce qui se passait ou quelle sorte d'arme était en train d'être testée. Le 12 décembre, la destruction du DC-8 Arrow à Newfoundland n'à apporter aucun indice que les américains et les canadiens savaient quelque chose sur la nature de l'arme probablement employée.

Par conséquent, après un temps d'attente suffisant pour tester nos réactions (s'il y en avait), les soviétiques se sont préparés à détruire réellement une navette après son lancement...

Destruction de Challenger, Janvier 1986

Comme le monde entier le sait, la navette Challenger a été lancé de Cap Canaveral en Floride après exposition à des conditions climatiques défavorables, et a explosée désastreusement peu après le décollage. L'évidence semble indiquer que, alors que le véhicule était en train de s'élever en condition difficile, une extrémité de son booster droit s'est brisée, a été projetée contre le réservoir principal provoquant sa rupture, une fuite importante de carburant, et une explosion catastrophique. Plusieurs autres anomalies existe encore cependant, et il est clair qu'un problème a existé avec au moins un des joints de booster. Les sept astronautes à bord du vol ont tous été tués dans la destruction violente du véhicule.

Bien sûr personne n'avait pris conscience que les Soviétiques avaient déjà testé un système anti-missile balistique en phase de lancement (LPABM) contre trois de nos précédents lancements de navettes. Ces "tirs à blanc" ont utilisé délibérément un "time-offset" pour décaler l'émergence explosive de l'énergie électromagnétique dans un lieu situé sur la trajectoire de la navette qui venait de décoller. Les tirs des tests décalés ont eu pour résultats un très grand "boum" au dessus du site de lancement après que la navette soit sortie indemne de la zone, mais n'ont pas détruit les navettes elles-mêmes. Par exemple, le boum du tir décalé a eu lieu 12 minutes après le lancement au soir du 26 novembre 1985. Un faisceau traçant (grande lumière dans le ciel) a même été utilisé sur ce lancement peu après le décollage. Le faisceau traçant a été photographié. De plus une autre photographie prise d'une séquence montre un autre éclair de lumière soudain, descendant et se terminant dans une explosion de lumière. C'était probablement un test déplacé spatialement du "mode pulsé" pour la destruction de la navette. L"explosion lumineuse" a dû être détectée en Union Soviétique et repérée par rapport à sa position déplacée intentionnellement. Cependant, un autre mécanisme a été utilisé pour provoquer la destruction de la navette elle-même.

Le 1er janvier 1986 la présence d'un signal réduisant la résistance des métaux, rajouté sur les émissions EM scalaires des systèmes LPABM soviétiques, a été détectée par un Frank Golden tout surpris. Il a lui-même vérifié expérimentalement à ce moment-là, la capacité du signal détecté de réduire la résistance des métaux. Golden a également annulé localement l'action du signal EM scalaire dans un test assez concluant en établissant (1) qu'il a existé et (2) ce que c'était. Le signal avait été apparemment préparé pour être utilisé contre un lancé de navette imminent.

Juste avant le lancé de la navette en fin janvier 1986, les soviétiques avaient accompli une manipulation climatique significative sur les U.S.A. Le Jet Stream avait été sévèrement détourné vers le sud dans le milieu des Etats Unis, se détournant encore vers la droite pour traverser le "panhandle" de la Floride. De l'air froid glacé du Canada a été aspiré très bas, en Floride sur l'emplacement de Challenger sur son aire de lancement. Cette exposition au froid en deçà de ses limites testées, fut probablement un facteur additionnel qui a contribué à la faillite de Challenger. Des signatures positives de la modification du climat et de la manipulation du Jet Stream par les Soviétiques ont été observées et photographiées par plusieurs personnes, particulièrement en Alabama et en Californie...

Le 28 janvier 1986, le système d'arme EM scalaire soviétique a été soudainement localisé dans la zone de lancement. La localisation impliquait que des fréquences plus élevées étaient présentes; celles ci sont absolument douloureuses pour les petits cerveaux tels que ceux des oiseaux, dont les hémisphères fonctionnent comme un détecteur et un interféromètre scalaire. Comme cela a été commenté par les présentateurs des informations nationales, étrangement les oiseaux ne volaient pas ce matin-là. Au lieu de cela, ils restaient au sol ou évitaient la zone, puisque le ciel au dessus de la zone leur était néfaste.

Alors que Challenger s'élevait, le signal réduisant la résistance des métaux a dû s'exprimer dans et autour des boosters peu après la mise à feu, puisque, la flamme du booster agit comme un détecteur/tuner spécial à "ion-plasma" pour le signal scalaire. L'effet de ce signal local est de "charger la masse dans le voisinage immédiat" avec le signal de résonance scalaire spécifique.

L'infortunée Challenger était vouée à l'échec. Après la mise à feu, la flamme du booster a agit comme un détecteur/amplificateur de plasma pour le signal réduisant la résistance des métaux du réseau soviétique "Pivert". Le métal dans et autour de la flamme du booster s'est lentement et progressivement affaibli en raison de l'acquisition des caractéristiques visant à réduire sa résistance. Cela a contribué à la fuite du booster à partir de l'étanchéité déjà mise à mal par le froid. De la fumée s'est échappée puis des flammes, contribuant au désastre imminent.

Des vents substantiels et des turbulences d'air au dessus du site ont accru le stress sur Challenger alors qu'il s'élevait dans cette zone. Cela aussi a contribué au désastre et a peut-être été créé délibérément par la manipulation soviétique du climat.

Comme Challenger était stressée, en fait un ou plusieurs étriers fragilisés ont cédé, libérant partiellement l'extrémité du booster droit. Une autre flamme ou lumière anormale a été observée sur le véhicule, et peut avoir représenté une petite "forme d'énergie en mode pulsée" supplémentaire produite par l'arme qui attaquait déjà Challenger. Le booster a oscillé, pivotant dans le réservoir et le fracturant. Une violente explosion a résulté du contact de la flamme avec l'épanchement du carburant liquide, détruisant le véhicule et tuant ceux qui étaient à bord...

En créant une exposition excessive de la navette au froid, en induisant une diminution de la résistance des métaux dans et autour des boosters mis à feux, et en ajoutant un "point intensivement chaud", les Soviétiques ont provoqué la fragilisation et l’autodestruction de Challenger peu après le décollage, d’une manière si subtile que les scientifiques de la NASA ne suspecteraient pas ce qui a provoqué réellement la mésaventure. Les Soviétiques avaient également reculé auparavant tous leurs chalutiers et navires qui normalement espionnent un tir de navette, pour prévenir une quelconque suggestion de présence proche ou implication soviétique dans l’accident catastrophique.

Quelques jours plus tard, des "signaux dans une gamme de haute fréquence", sporadiquement intenses, étaient encore présents sur le réseau, au moins un "hinge-point( ?)" à Birmingham en Alabama a confirmé cela. Du 1 au 4 février 1986, de nombreux oiseaux volaient par inadvertance dans la zone lorsqu'une explosion intense eut lieu, et les oiseaux sont tombés morts du ciel en nombre important....

Malheureusement, la suffisance bureaucratique des scientifiques orthodoxes d'occident a matériellement renforcé le processus de duperie soviétique. La plupart des cadres scientifiques d'occident - particulièrement dans les activités de développement des armes - ont continué à voir les Soviétiques comme des paysans ignorants, encore en train d'essayer de nettoyer la boue de leurs bottes. Ce point de vue est, bien sûr, totalement faux et injustifié.

Quelques exemples suffisent pour réfuter cette attitude. Dans les mathématiques non-linéaires, l'ingénierie et la science, les Soviétiques ont devancé leurs homologues occidentaux depuis le début. L'effet (EMP) d'impulsion électromagnétique d'une explosion nucléaire est apparu dans la littérature scientifique ordinaire soviétique avant même que les scientifiques occidentaux soient conscients que l'effet existait. Les soviétiques continuent à être en tête au niveau mondial dans la soudure explosive, l'usinage et la soudure du titane, etc. Tandis que les scientifiques soviétiques montrent peu d'inclinaison à fabriquer des bonnes machines à laver, ils produisent certainement des chefs d’œuvre de technologie -- et au-delà -- dans n'importe quel domaine dans lequel ils ont focalisé leurs efforts principaux. (On devance les soviétiques dans certains domaines tels que le matériel informatique, les logiciels informatiques, miniaturisation, etc.).

Une fois auparavant, une nation moderne, les Etats-Unis, avait développé secrètement une arme de grande capacité et l'a utilisée pour mettre à genoux un adversaire puissant, le Japon... Les frappes atomiques incroyables à Hiroshima, et Nagasaki, ont montré une fois pour toutes que dans l'age moderne la surprise technologique peut s'avérer désastreuse instantanément. Donc dans notre arrogance scientifique, nous avons présumé que cela ne pourrait jamais se passer pour nous, et que le scénario "arme secrète" ne sera jamais répété. Au contraire, il A EU LIEU de nouveau, quelqu'un d'autre l'a fait, et cela s'est passé pour nous.

Il est également de bon ton à l'Ouest de croire que toutes les lois de la physique sont déjà découvertes. Nous affirmons que nous les connaissons toutes. Pendant que nous étions en train de chanter orgueilleusement cette mélodie, les soviétiques étaient en train de découvrir progressivement de nouvelles lois en secret, ainsi que de nouveaux moyens de faire échouer les anciennes lois. Notre défense est stratégique, nous comptons sur nos capacités d'attaque, notre énorme arsenal nucléaire... Si cette capacité d'attaque était annihilée ou détruite par les armes secrètes soviétiques, nous serions impuissants à prévenir notre propre destruction et la domination soviétique sur le monde.

Nous nous sommes vu comme indestructible, confiant dans la force de notre défense. Donc littéralement nous avons été dépouillé de notre défense. Les armes énergétiques soviétiques sont maintenant vraiment capable de détruire notre défense, notre contrée, nos forces armées sur le champ de bataille, et notre population, rapidement et efficacement. Nous avons une nouvelle lacune de proportions monumentales: pas une lacune de missile, pas une lacune de bombardier ou de sous-marin, ni même une lacune de laser ou de rayon de particule. Nous avons une lacune "d'Electromagnétismes scalaires ou d'Electrogravitation".....

Après 1895, les physiciens ne pouvaient plus utiliser les mathématiques des déplacements physiques continus pour modéliser l'Univers. La théorie quantique exigeait ce qui était alors des changements radicaux dans les hypothèses de causalité. Les atomes émettaient, ou n'émettaient pas, des radiations non sur des bases déterminées mais selon des probabilités; les constituants basiques de la matière et de l'énergie étaient soit des particules ayant des propriétés semblables aux ondes, soit des ondes ayant des propriétés semblables aux particules, selon comment et quand vous les mesuriez; position et vitesse ne pouvaient pas être mesurées simultanément à un degré de précision quelconque; l'état d'une particule est déterminé uniquement quand vous la mesurez, et cette mesure détermine aussi immédiatement l'état d'une particule reliée qui est si éloignée que l'information ne peut lui parvenir depuis la première particule. Ces difficultés ne signifient pas que la théorie quantique est imprécise; elle est hautement précise. Mais, à la différence de la théorie de la relativité, elle n'explique pas l'Univers par la voie déterministe classique.

L'un des problèmes des physiciens pour la compréhension et l'assimilation de la théorie quantique était dû au fait que l'interprétation de toutes les mesures est complètement liée aux hypothèses théoriques concernant ces mesures. Si les hypothèses qu'on établi à propos des mesures au niveau microphysique (quantique) étaient des hypothèses classiques, les mesures n'auraient aucun sens. Eisenbud (8) disait cela.

Finalement, la théorie devient si familière que nous ne réalisons plus vraiment son importance dans l'interprétation de l'observation... Lorsque la théorie échoue, cependant, les connections familières entre ses constructions mentales et ce qui est observé sont brisées. Nous devons retourner alors aux observations pures et à leurs interrelations observées, et essayer de construire à partir d'elles de nouvelles structures théoriques adaptées.

L'Électromagnétisme scalaire c'est l'Electrogravitation

L'électromagnétisme scalaire est une extension de l'électromagnétisme (EM) actuelle qui inclut la gravitation. C'est une électrogravitation unifiée et, ce qui est plus important, c'est une théorie unifiée. Ses bases ont été découvertes par Nikola Tesla.

Que ceux qui ont des oreilles entendent.

Voici le secret de l'antigravité.

La "charge électrique" d'une particule chargée -- comme celle des particules chargées d'un atome ou celle des protons de son noyau -- représente une différence d'intensité (potentiel) de flux entre la particule locale et son vide environnant. C'est l'épanchement continuel de la charge gravitationnelle ainsi que de la charge électrique. Si cet épanchement est inversé ou arrêté, il s'ensuit un effet radical sur la charge gravitationnelle. Le potentiel-5 et la charge-5 sont devenus un potentiel-4-G et une charge-4-d respectivement. Donc "charger" un objet avec sa structure EM scalaire revient à le charger gravitationnellement. Maintenant le seul "canal d'épanchement" est à travers le champ de force 4-G. De plus, dans un noyau les nucléons vont et viennent continuellement entre proton et neutron, ce qui fait que la charge électrique est "éparpillée" à travers le noyau et partagée par tous les nucléons.

On peut rajouter que chaque élément (en fait chaque isotope) a son propre et unique "pattern d'ensemble" de fréquences scalaires d'expansion de Fourier, d'amplitudes, etc. Ce pattern peut, bien sûr, être reproduit artificiellement et être émis par des émetteurs EM modifiés. Il y a, cependant, une sorte de pattern (EG) d'EM scalaire "clef maîtresse" pour les nucléons (protons et nucléons s'intervertissent en échangeant des courants de charge virtuels).

Si on inverse la charge par l'inversion de cette structure, et puis on applique cette "charge inversée à une masse", pour l'observateur externe la masse ainsi chargée devient de plus en plus légère, et son inertie de moins en moins importante. En fait cela semble (à l'observateur) acquérir une masse négative et une inertie négative, et donc subit une accélération l'éloignant de la Terre. L'objet tombe vers le haut au lieu de tomber vers le bas.

Il y a aussi des effets de temps étranges ; cette objet peut se déplacer plus lentement à travers le temps que l'observateur dans le laboratoire, ou même se déplacer en arrière dans le temps par rapport à l'observateur dans le laboratoire. Ne croyez pas tout ce qu'on vous enseigne sur la relativité ; aucune de ces personnes n'a jamais fabriqué une seule situation de relativité générale, et rien de ce qu'ils enseignent en relativité générale n'est basée sur l'expérience directe. Il a déjà été prouvé expérimentalement que ce qu'ils enseignent est erronée.

Voici le concept d'un détecteur EG scalaire pour des ondes EG scalaires. Voici le détecteur d'onde scalaire Bendini, adapté d'un concept original par Dea et Faretto.

L'idée est vraiment simple: installez une puissante barre aimantée à l'intérieur d'une cage de Faraday reliée à la terre. Ensuite installez une bobine ouverte aux extrémités longitudinalement au dessus de l'aimant de façon qu'une ligne qui traverse l'axe longitudinal de l'aimant passe au travers de l'axe longitudinal de la bobine au dessus de lui. L'extrémité ouverte de la bobine ne doit pas toucher l'aimant.

Connectez l'autre extrémité de la bobine à un condensateur variable, afin que la bobine et le condensateur forment un circuit oscillateur-L-C-série réglable. La sortie du condensateur est connectée à un préamplificateur à l'intérieur de la cage. Une tige de réglage pour le condensateur est très soigneusement placée à travers un petit trou de la cage pour permettre le réglage depuis l'extérieur.

La sortie du préampli est un câble blindé qui passe à travers un petit trou de la cage vers un oscilloscope adjacent. Le blindage du câble est aussi mis à la terre au potentiel de référence du sol.

La théorie est celle qui suit: Supposez qu'une onde électromagnétique normale apparaisse à l'intérieur de la cage, au dessus de l'aimant ou juste à proximité, dans ce cas une oscillation accouplée apparaît dans le champ de l'aimant, et cette oscillation est transférée à la bobine qui est juste au dessus de lui. Si l'oscillation est à l'intérieur de la fourchette de fréquences sur laquelle le circuit oscillateur LC est accordé, une détection a lieu, celle-ci est amplifiée par le préampli puis elle arrive à l'oscilloscope, où elle est affichée sur l'écran.

Remarquez que le détecteur détecte une onde EM normale. Maintenant notre problème est: Comment faire en sorte qu'une onde EG soit détectée? Et comment s'assurer que nous ne détectons pas une onde EM ordinaire venant de l'extérieur? En fait cela est simple. Les ondes ordinaires (excepté pour les très basses fréquences) seront mises à la terre par le bouclier Faraday, et ne pénètreront pas la cage. Donc ces ondes EM normales ne peuvent pas entrer dans la cage et apparaître au dessus de l'aimant, elles ne seront pas détectées. Les ondes EG scalaires, à l'inverse, pénétreront dans la cage puisqu'elles ne se couplent pas avec les électrons conducteurs dans le métal de la cage. Au dessus du pôle de l'aimant, l'espace-temps est localement courbé, après tout, un pôle est un potentiel scalaire magnétostatique, qui est une partie du conglomérat appelé "potentiel-G". Le pôle représente une augmentation (ou une diminution, selon que ce soit un pôle nord ou un pôle sud) dans la composante magnétostatique du potentiel-G local. C'est une courbure de l'espace-temps. Une onde EG entrant dans cette région amène une variation de la composante du potentiel-G magnétostatique, qui s'épanche dans la bobine comme une onde EM ordinaire.

Une autre façon de voir le détecteur est de modeler l'onde EG comme une onde longitudinale, et une onde EM ordinaire comme une onde transverse. Lorsque l'onde EG pénètre la région de l'espace-temps courbé au dessus de l'aimant, pour la bobine ("l'observateur" dans ce cas!) l'aspect longitudinal de l'onde EG apparaît comme un mouvement rotatif alterné, de telle sorte qu'une composante d'oscillation transversale est présente. Cette composante transversale apparaît à la bobine comme un champ EM ordinaire, et donc le circuit LC le détecte s'il est dans sa propre bande de fréquence.

Une autre manière de voir la situation c'est de réaliser qu'une onde EG approchant l'aimant induit une oscillation qui a augmenté le potentiel scalaire magnétostatique (force polaire) de l'aimant. Par conséquent, l'aimant est un receveur pour les ondes scalaires, lesquelles sont détectées lors de leur propagation, comme une oscillation de la puissance du champ magnétique de l'aimant. Le couplage de la bobine au champ magnétique oscillant crée un flux de courant oscillant dans le condensateur, cela fait osciller le voltage d'entrée au préampli, qui amplifie et génère le signal pour l'affichage à l'oscilloscope.

Il est important de se rappeler qu'un potentiel magnétostatique et un potentiel électrostatique peuvent être mis en oscillation par une onde EG scalaire. En plaçant un matériel magnétique dans une cage Faraday, l'oscillation du potentiel scalaire magnétostatique (puissance polaire de l'aimant) peut être utilisée en tant que mécanisme de détection EG. En plaçant un matériel chargeable (électriquement) dans une cage de Faraday, l'oscillation du potentiel scalaire électrostatique peut être détectée. (Des exemples possibles des derniers types de détecteurs ont été donnés par Hodowanec, "Radio Electronics", Avril 1986.)

Remarquez aussi qu'on peut détecter des ondes à un niveau de référence et pas à un autre. Le changement de potentiel de la référence zéro de la mise à la masse du détecteur Bendini affecte la détection. Pour regarder à l'intérieur d'une porteuse EM normale (telle que la porteuse du "Pivert" soviétique) et voir quels signaux scalaires elle apporte, la porteuse peut être utilisée pour référencer la mise à la masse du détecteur Bendini. Pour produire un analyseur de spectre, utilisez simplement des séries supplémentaires de circuits d'accords LC en parallèle (mettez plusieurs cosses de connexions sur la bobine, et reliez chaque cosse à un condensateur d'accord séparé de capacité différente). A nouveau, la variation du niveau de référence zéro est importante, tout comme la variation de la puissance de l'aimant. Frank Golden a aussi inventé une excellente série de détecteurs d'ondes scalaire basés sur des principes déposés complètement différents.

Le résultat est: on peut vraiment détecter et mesurer rigoureusement des ondes scalaires EG, quand on considère les grandes sommes d'argent actuellement affectées pour enterrer de grands cylindres d'aluminium, on se demande pourquoi quelques fonds ne peuvent être alloués à quelques chercheurs non-orthodoxes par l'Académie Nationale des Sciences pour financer la détection et la création prouvées des ondes électrogravitationnelles...

Voici expliqué un nouveau genre de résonance: la résonance électromagnétique scalaire, ou résonance électrogravitationnelle.

En premier, imaginez que vous ayez une cavité résonnante standard, dans cette cavité on a une onde EM résonnante qui va et vient, selon les conventions, le vecteur de champ-E et le vecteur de champ-B sont à angle droit dans ce front d'onde en mouvement. Lorsque l'onde va et vient, les vecteurs varient en allant et venant ; cependant, à n'importe quel point entre les parois, les deux vecteurs ont toujours la même valeur. Donc notre onde EM résonnante forme une onde stationnaire dans la cavité.

Maintenant imaginez qu'un second front d'onde, précisément comme le premier et de la même fréquence, est superposé au premier et voyage avec lui. Cette seconde onde -- "l'anti-onde" -- a ses vecteurs forces déphasés de 180 degrés d'avec les vecteurs forces de l'onde de référence. En conséquence la somme des champs-E et des champs-B des deux ondes superposées est toujours égale à zéro, en n'importe quel point de la cavité. Pour un observateur externe, la cavité contient des champs de forces électromagnétiques non-ordinaires, d'où une énergie EM non-ordinaire.

Cependant la densité d’énergie d’une onde sinusoïdale EM dans le vide est donnée par :

Densité 2 [E + B] / 8 Pi

Cette densité d’énergie est toujours positive, de là la densité d’énergie des deux ondes en n’importe quel point entre les murs est égale à :

2 2 [E +B] / 4 Pi

où E = E(x) ; B = B(x)

Ainsi la densité d’énergie du vide varie avec X, rigoureusement, puisque la résultante des champs E et B est de zéro, cela décrit une onde gravitationnelle stationnaire. En conséquence nous avons une onde EG stationnaire existant dans la cavité, voici un exemple de résonance scalaire. Rigoureusement la cavité a une masse et une inertie, pour un observateur extérieur, en résultat des deux courbures d’espaces-temps qu’elle contient.

Notez que dans un demi cycle la densité d’énergie du vide est plus grande qu’en ambiance, et dans l’autre demi cycle elle est moins grande ; dans la zone d’un demi cycle le temps s’écoule à un rythme plus rapide que pour l’observateur ambiant, et dans l’autre demi cycle le temps s’écoule à un rythme plus lent que pour l’observateur ambiant. Une moitié du cycle semble contenir la charge électrique et l’autre semble contenir la charge positive. Un demi cycle semble contenir un pôle nord (potentiel scalaire magnétostatique positif), et l’autre demi cycle semble contenir un pôle sud (potentiel scalaire magnétostatique négatif).

Peut-être que maintenant on peut commencer à comprendre pourquoi un électron en continuelle accélération sur son orbite atomique n’émet pas d’énergie EM, en complète violation des équations de Maxwell, l’électron n’est pas comme tel mais un aspect complexe.

La résonance scalaire n’est pas dans les manuels conventionnels.

La résonance scalaire est une muli-résonance électromagnétique particulière de somme zéro, de sorte qu’elle n’agit pas d’une façon électromagnétique. Une résonance scalaire est une onde électromagnétique stationnaire, elle peut être produite électriquement, mais elle n’est pas électrique dans son comportement. Dans n’importe quelle résonance scalaire, l’espace-temps est courbé et c’est l’ampleur (et direction) de cette courbure d’espace-temps qui oscille sous forme « d’onde stationnaire ». Par rapport au stress du vide moyen, la moitié d’une onde sinusoïdale stationnaire est extensible, l’autre moitié est compressible. Cependant, cela est par rapport au stress ambiant local du vide. La « masse » d’une particule est juste une caractéristique exhibée par une résonance scalaire piégée, en fait ce piégeage est fait par le « spin » de la particule individuelle. Le concept de « masse » peut être comparé avec le concept de « capacité ». Ce qui signifie qu’une masse est un accumulateur d’ondes scalaires ; c’est-à-dire de résonances scalaires. Elle se « charge » et « décharge » continuellement par absorption et émission d’ondes scalaires depuis et vers le flux d’ondes scalaires du vide ambiant. En conséquence la magnitude d’une masse peut être définie en terme de valeur absolue de ce taux de « commutation » (absorption = flux entrant ; émission = flux sortant). Pour des détails sur cela voir (Bearden, T.E. « Quinton/Perception Physics : A Theory of Existence, Perception, and Physical Phenomena, » Mars 1973, AD 763210, disponible à NTIS).

Dans l’espace-temps linéaire normal, « charge » et « décharge » sont égales dans toutes les directions ; donc la masse exhibée est identique dans n’importe quelle direction. Par rapport à l’équilibre du flux de « l’observateur externe », un objet en mouvement rencontre une quantité accrue de taux de flux le long de sa ligne de mouvement, exactement comme un objet se déplaçant sous une pluie torrentielle rencontre plus de gouttes de pluie par seconde dans la direction de sa trajectoire, que ne le fait un objet stationnaire. La rencontre d’un flux accru d’ondes scalaire (par rapport à l’observateur externe) force l’objet en mouvement à absorber et émettre des ondes scalaires à un taux plus élevé le long de sa direction de mouvement que lorsqu’il ne bougeait pas. Donc pour l’observateur externe, la masse de l’objet s’est accrue, en ce qui concerne n’importe quelle force perturbante le long de sa ligne de mouvement.

Cependant, orthogonalement à sa ligne de mouvement, le taux de flux est précisément le même que quand l’objet est au repos, donc, vu par l’observateur externe, la masse de l’objet en mouvement n’a pas changé par rapport aux forces perturbantes orthogonales. Ainsi se trouve expliqué les deux parties de l’un des grands mystères de tous les temps, la relativité : (1) comment la masse d’un objet s’accroît selon son mouvement et, (2) pourquoi la masse s’accroît par rapport à sa ligne de mouvement et pas orthogonalement à elle.

L’inertie d’une particule est due à sa masse, c’est-à-dire à la magnitude totale de sa résonance scalaire piégée. L’attraction gravitationnelle entre deux masses est due à leur courbure d’espace-temps, de plus, la masse est comme une capacité, elle peut capturer des ondes scalaires complémentaires en tant que résonance piégée et de là accroître sa magnitude ou « charge inertielle » ; ou bien elle peut se décharger de plus d’ondes scalaire qu’elle n’en absorbe et de là diminuer sa magnitude ou « charge interne »...

Ces ondes scalaires émises par la résonance sont émises comme un ensemble de patterns de la résonance, elles peuvent donc être considérées comme constituant un courant de résonances scalaires quittant l’objet accumulateur de masse. Les ondes scalaires absorbées dans une résonance piégée peuvent être considérées comme constituant un courant de résonance scalaire pénétrant l’objet accumulateur de masse, donc il est approprié de dire qu’une résonance scalaire est capable de « couler ».

En conséquence, il est possible d’accroître directement la masse d’un objet, en lui transmettant des ondes EM scalaires pour qu’il les absorbe. (Cela signifie qu’il y a plus d’ondes scalaires à pénétrer l’objet qu’à le quitter, donc l’objet agit comme un accumulateur augmentant sa charge interne. Cela se fait en s’assurant que le potentiel de référence de l’émetteur d’onde scalaire est plus élevé que le potentiel de référence de l’objet irradié.)

Il est également possible de diminuer directement la masse d’un objet en lui transmettant des ondes EM scalaires, de façon qu’il émette plus qu’il n’absorbe. (Cela signifie qu’il y a plus d’ondes scalaires à quitter l’objet qu’à le pénétrer, donc l’objet agit comme un accumulateur diminuant sa charge interne. Cela se fait en s’assurant que le potentiel de référence de l’émetteur scalaire est plus bas que le potentiel de référence de l’objet irradié.)

Comme on peut le constater, « l’émetteur » d’onde scalaire est en réalité quelque peu comparable à une pompe à chaleur ; il peut agir soit comme un « émetteur d’énergie » ou soit comme un « extracteur d’énergie », selon la différence de potentiel entre « l’émetteur » et le « receveur ».

Une résonance scalaire peut avoir une structure spécifique : tant dans ses aspects courbures spatiales et fréquences que dans ses aspects « débit d’écoulement du temps ». En effet, du point de vue scalaire chaque objet à son « modèle scalaire » individuel lequel est une empreinte digitale unique. Puisque cette empreinte est spatio-temporelle, c’est un produit de l’histoire passée entière de cet objet. Donc – d’un point de vue scalaire – deux objets ne peuvent être identiques.

Cela montre un autre potentiel plutôt étonnant : si un modèle scalaire suffisamment précis d’un objet peut être « irradié » et mis en résonance par des ondes scalaires, on peut, à distance, créer de l’énergie à l’intérieur de l’objet ou en extraire, tout comme un diapason stimulé peut en exciter un autre à distance par résonance sympathique. Je vous laisse vérifier le rapport de cette assertion à la clairvoyance, radionique, vision à distance, etc.

Pour le sceptique, cependant, nous devons signaler que -- rigoureusement -- la mécanique quantique exige que, continuellement, dans n’importe quelle région localisée de l’espace-temps, le « pattern » de n’importe quel objet dans l’univers apparaisse momentanément en l’état virtuel, d’un point de vue purement statistique seulement. Aussi longtemps que la situation reste statistique, n’importe quel lieu dans l’univers peut continuer d’avoir les « fantômes » de tout ce qui est présent là, dans un pattern fin et éthérique, et le monde observable n’en sera pas affecté. Cependant si on peut distinguer et « charger » scalairement ou « décharger » des patterns individuels dans ce « royaume-fantôme », l’action à distance est directement possible, comme l’est la matérialisation et la dématérialisation. Si on accepte que même une pensée elle-même produit un tel « pattern-fantôme » virtuel dans le flot de particules virtuelles du vide, alors il est au moins théoriquement possible de matérialiser des pensées et des images pensées.

Nous sommes entrés dans une nouvelle sorte de réalité où les anciennes règles et les anciennes limitations ne s’appliquent pas nécessairement.

Comme signalé, nous pouvons grandement simplifier le problème en le considérant comme des « courants de résonances scalaires », ces courants coulent du potentiel le plus élevé vers le potentiel plus bas, indépendamment de ce que nous considérons « émission » ou « réception ». En effet, émettre à un potentiel plus bas c’est recevoir, et recevoir à un potentiel plus haut c’est émettre. Donc « l’émetteur-récepteur » est un système spécial où en biaisant simplement deux nœuds différemment on détermine dans quel sens la résonance scalaire s’écoulera. On peut augmenter et diminuer la masse et l’inertie d’un objet, simplement en biaisant d’une manière appropriée les deux nœuds de l’émetteur-récepteur.

Lors d’une expérience accidentelle d’une durée de quelques heures, Golden a chargé une zone de sorte que, localement toutes les horloges ont été faussées, cela incluait des horloges électriques, des montres à piles et une horloge ancienne à pendule, le débit du flux de temps lui-même a été apparemment altéré dans la zone locale par la charge accumulée, laquelle a mis quatre jours à s’épancher et se décharger. Au bout de quatre jours de décharge, toutes les horloges et les montres sont revenues à la normale.

Si nous faisons interférer deux émetteurs dans une région de grande énergie – telle que le noyau en fusion de la Terre elle-même – et réglons l’émetteur négativement, nous pouvons extraire une énergie énorme directement de cette source !

En effet, c’est précisément par une légère variation de cet effet que les Soviétiques obtiennent l’énergie énorme avec laquelle ils alimentent leurs armes EM sacalaires stratégiques « continent-buster » incroyablement puissantes. Des paires de fréquences scalaires – séparées de 12 kilohertz – sont émises dans la Terre elle-même sur certaines portions de la courbe de fréquence de la « gigantesque résonance scalaire » de la Terre. Le positionnement approprié des émetteurs l’un par rapport à l’autre produit une haute différence de potentielle (voltage) entre eux. En les positionnant simultanément négativement par rapport au noyau en fusion de la Terre, il en résulte un courant de résonance scalaire depuis le noyau vers les deux émetteurs.

Dans la « boucle extérieure » entre les deux émetteurs scalaires, apparaît un voltage gigantesque et un courant électrique gigantesque qui peut être capturé par des moyens appropriés, cette puissance électrique est capturée et transmise à des systèmes d’armes EM scalaires incroyablement puissantes. Là des accumulateurs spéciaux couplés à des commutateurs sont utilisés pour fournir d’énormes quantités de puissance à chaque arme.

Juste avant le 1er mai 1985 l’Union Soviétique a effectué un test opérationnel de son complexe entier d’armes EM scalaires stratégiques. Ce test a été détecté et surveillé périodiquement par Frank Golden, quelques 27 de ces « vannes géantes d’énergies » soviétiques ont été verrouillés dans le noyau en fusion de la Terre, produisant une résonance scalaire forcée de la planète entière sous nos pieds, sur 54 fréquences contrôlées. Le reste du spectre de fréquences scalaires était embrassé par littéralement des centaines d’émetteurs scalaires soviétiques : probablement la commande et le contrôle entier du système scalaire stratégique des sous-marins, les plus hauts centres de commandes, les commandes à distances, etc., étaient activés dans l’exercice gigantesque.

Durant plusieurs jours le system était en action à une échelle époustouflante, apparemment faisant partie de la célébration hautement commémoré du 40ème anniversaire de la fin de la deuxième guerre mondiale.

Ironiquement pas un seul service de renseignement, laboratoire, ou scientifique américain n’a détecté cet exercice monstrueux pour le nouveau leader soviétique, Gorbatchev. Pas un d’entre eux n’avait un détecteur de rayonnement EM scalaire, et aucun d’entre eux ne dira – officiellement – que l’exercice ait jamais eu lieu.

Création d’énergie à distance

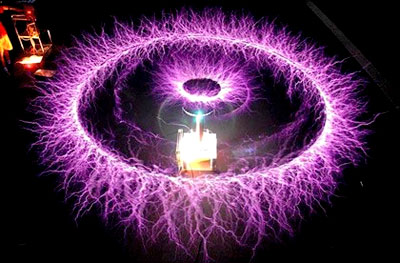

Un dispositif plus utile est obtenu en utilisant un interféromètre scalaire où les deux émetteurs émettent des rayons qui se croisent à distance. Dans la zone d’interférence, une bouteille d’énergie est créée.

En réglant les potentiels de référence de l’émetteur bien au-dessus de ceux de la bouteille d’énergie distante, une énergie EM émerge dans cette zone, dans ce cas l’interféromètre fonctionne dans le mode Exothermique.

En réglant les potentiels de référence de l’émetteur bien au-dessous de ceux de la bouteille d’énergie distante, une énergie EM est extraite de la zone distante et émerge de l’émetteur, dans ce cas l’interféromètre fonctionne dans le mode Endothermique.

Si l’émetteur émet continuellement, l’effet dans la zone distante est continu. Si les émetteurs émettent par pulsation et que les deux pulsations se rencontrent dans la zone d’intersection distante, alors une extraction ou émergence explosive d’énergie a lieu dans la zone d’interférence distante, selon que l’interféromètre fonctionne dans le mode endothermique ou exothermique.

[Note de J.Frendelvel: un exemple photographique d'interférométrie scalaire est présenté en document annexe , ce lien est redonné à la fin de ce document]

Mode exothermique (interféromètre scalaire)

Pour un interféromètre scalaire, « del phi » (le gradient du potentiel) s’applique entre le site de l’émetteur et le site d’intersection distant, pas à l’espace existant entre les deux. Donc on parle du « flux d’énergie » existant entre l’émetteur et l’intersection – sans rien entre. Dans l’espace intermédiaire, toute l’énergie existe comme un potentiel artificiel verrouillé (potentiel d’écoulement du gradient).

Dans le mode Exothermique le potentiel terre de l’émetteur est réglé bien au-dessus du potentiel terre du vide ambiant, l’énergie entre dans l’émetteur et « disparaît », pour « réapparaître » dans la zone d’interférence distante.

Si une émission continue d’onde est utilisée, l’énergie apparaît de manière continue dans la zone distante.

Si une émission pulsée est utilisée et prévue pour que les deux pulsations scalaires se rencontrent dans la zone distante, une énergie explosive y apparaît alors.

Si des fréquences multiples sont émises à la manière d’une expansion de Fourier d’une forme géométrique particulière, alors une forme d’énergie tri-dimensionnelle apparaît à l’intersection distante. De cette façon une coquille (ou obus) sphérique ou hémisphérique (un globe ou un « dôme » d’énergie EM) peut être créé à distance, si une émission pulsée est utilisée, ce sera une émergence impulsive ou explosive de cette forme d’énergie, si une émission continue est utilisée, ce sera une forme rayonnante continue.

En alimentant des émetteurs incroyablement puissants avec de grandes quantités d'énergie extraites du noyau en fusion de la Terre grâce à des « vannes d’énergies », de très vastes globes sphériques et dômes hémisphériques d’énergie EM peuvent être créés à distance. L’énergie dans la « coquille » d’interférence d’une telle sphère ou hémisphère, est suffisamment dense pour soulever le problème de Dirac depuis la mer de vide de Dirac, ainsi la coquille contient un plasma rayonnant.

De telles signatures d’obusiers scalaires ont été vues de nombreuses fois sur les océans, particulièrement sur le nord Pacifique par des avions de ligne allant ou venant du Japon. (Rappelez-vous il y a quelques mois la grande histoire du vol JAL dans lequel tous les passagers et l’équipage ont vu un «OVNI » sphérique géant.) De tels globes et dômes de lumières ont été vus également bien à l’intérieur de l’Union Soviétique, par des observateurs en Afghanistan et par des pilotes d’avion atterrissant en Iran.

Dans le mode exothermique impulsif, un grand flash visible peut avoir lieu si l’énergie EM est produite dans le spectre visible. Des flashes dans l’infrarouge peuvent également avoir lieu si l’énergie émergente est dans cette bande spectrale. En septembre 1979 nos satellites Vela ont détecté un tel grand « flash nucléaire » sur l’Atlantique Sud, au large des côtes du sud de L’Afrique, un second « flash nucléaire » a été détecté par les satellites Vela en 1980 lequel était dans l’infrarouge uniquement. Il y a quelques années, une série de « flashes » et « boums » anormaux ont eu lieu au large de la côte est des Etats Unis, ils étaient dus à l’orientation, alignement et enregistrement, d’un ou plusieurs « obusiers scalaires » -- des interféromètres EM scalaires dans le mode exothermique.

De grands « boums » ont eu lieu sur le site de lancement de la navette à Cap Canaveral, associés avec trois lancements de navettes avant la fin novembre 1985. C’étaient les essais de ces obusiers EM scalaires exothermiques, qui étaient en train d’être testés en tant que système ABM en phase de lancement soviétique, dans ce mode, les pulsations scalaires des deux émetteurs sont injectées dans des « canaux » EM scalaires référence-zéro spéciaux lesquels sont établis dans les transporteurs EM des radars au-delà-de-l’horizon de Woodpecker (Pivert). Les pulsations scalaires voyagent par ces canaux, voyageant dans le rayon EM ordinaire de l’émetteur et le suivant dans sa courbure autour de la Terre dans le guide d’ondes ionosphérique terrestre. Les pulsations scalaires sont prévues, mises en phase, et orientées afin de rencontrer la navette s’élevant. Dans ces tests les émissions étaient décalées dans le temps afin que la navette ne soit pas détruite en fait, mais le système pouvait être testé contre des lancements réels de navettes aux U.S. Les utilisations spécifiques de ces différents modes exothermiques seront abordées dans des sections ultérieures de ce dossier.

Dans le mode endothermique, le réglage de l’émetteur est tel qu’une énergie est extraite de la zone d’intersection distante, pour ré-émerger de l’émetteur, là l’énergie doit être capturée et déployée pour ne pas griller les émetteurs. Lorsque de très grandes quantités d’énergies sont extraites de zones distantes, les Soviétiques utilisent souvent une méthode « dépôt » de capture et stockage temporaire dans un accumulateur, l’énergie calorifique émergeant des émetteurs, un second obusier en mode exothermique est alors alimenté par une « vanne d’énergie scalaire » établie dans l’accumulateur. Cet obusier est focalisé sur le site dépôt distant – souvent Bennet Island, où des échappements sont continuellement observés par des satellites météorologiques américains.

Dans le mode endothermique impulsif, l’énergie est extraite impulsivement de la zone d’intersection distante, le résultat dans l’atmosphère est un refroidissement très pointu ou « explosion froide », il en résulte aussi un type de boum et de grondement souvent associé au tonnerre après l’éclair de la foudre.

Le 9 avril 1984 l’Union Soviétique a testé une telle « explosion froide » au large des côtes du Japon, près des îles Kuril, la « zone froide » a soudainement induit une basse pression, l’eau océanique a été brusquement absorbée de l’océan formant un nuage dense. Puis l’air s’est précipité dans la zone de basse pression et a forcé le nuage a s’élever en formant un champignon tout comme dans une explosion atomique excepté l’absence d’un flash et l’absence d’onde de choc se répandant depuis le centre de l’explosion.

Lorsque le nuage s’élève, il augmente de volume par mixage – de la même façon qu’un cumulonimbus se développe, sauf qu’il est beaucoup plus rapide, dans ce cas le nuage s’est élevé à approximativement 18000 mètres en 2 minutes environ, en gonflant jusqu’à atteindre un diamètre d’environ 300 kilomètres. L’incident a été vu par les pilotes et les équipages de plusieurs Boeing 747, des avions de lignes qui voyageaient dans le voisinage. Quelques temps après, une photo du secteur est arrivée, prise par un satellite météorologique américain, le nuage dans cette photo avait une distribution de densité anormale, différente de celle de tous les autres nuages dans cette zone.

Le « grand oeil » de Tesla pour la vision à distance

Nikola Tesla a conçu une utilisation très spéciale pour son interféromètre scalaire endothermique, il l’a conçue pour produire son « grand œil pour voir à distance ». Le système utilisé pour réaliser cela est juste légèrement endothermique, de manière que seule une petite quantité d’énergie est extraite de la cible distante, au fur et à mesure un receveur ouvert « scanne » les rayons, temporellement, d’un côté à l’autre et de haut en bas. En scannant un autre rayon traversant la zone d’intersection, ayant des pulsations en phases, une représentation encore meilleure peut être obtenue. Finalement le receveur génère une représentation de l’énergie qui a été extraite de différents endroits de la zone endothermique distante, en affichant les signaux reçus sur un écran de scanner approprié, une représentation de la scène distante peut être créée. C’est un genre particulier « d’interféromètre micro-ondes », et – avec les techniques modernes – les images obtenues peuvent être étonnamment bonnes. Avec le développement, cela pourrait même devenir aussi bon que les images obtenues par les radars d’acquisitions en vue de côté. Il est assez intéressant de noter que, puisque les rayons scalaires pénètreront assez facilement sous la surface de la terre et des océans, on peut aussi regarder sous la surface de la terre et des océans avec ce type de scanner par interférométrie scalaire.

L’importance de cette capacité de reconnaissance stratégique et tactique est évidente. Camouflage, couverture et dissimulation n’ont plus aucun effet face à un tel système. On peut facilement observer l’intérieur des bâtiments et dans les équipements souterrains. Avec un petit système comme celui-là, les fusiliers marins américains à Khe Sahn n’auraient pas eu de grandes difficultés à situer les tunnels qui étaient creusés en permanence sous le périmètre par le Viet Cong, et les cibles sous les cahutes de la jungle sont directement visibles.

Il est aisé d’imaginer que ce système est facilement adaptable à l’utilisation sous-marine. Un type de radar « sous-marin ». Avec un tel dispositif, le problème posé par les sous-marins nucléaires en plongée est résolu. Par exemple, une zone entière peut être continuellement fouillée, exactement comme des systèmes de radars d’acquisitions le font maintenant. Un sous-marin peut être détecté et suivi à la trace alors qu’aucun de ses détecteurs ordinaires ne détectera quelque chose de particulier. En utilisant une paire séparée de rayons dans le mode exothermique, de puissantes pulsations scalaires peuvent être envoyées au sous-marin, s’inter-croisant au niveau du sous-marin dans un violent effet EMP partout dans le sous-marin et son armement. Ainsi le sous-marin et tous ses missiles sont détruits instantanément.

Ou bien, une transmission exothermique continue peut être employée par l’arme de visée à un niveau de puissance moindre, interférant progressivement avec les systèmes électriques du sous-marin et provoquant une perte de contrôle. Le sous-marin coule alors, puis est écrasé par la pression des profondeurs et implose.

C’est précisément ce scénario qui semble être arrivé au sous-marin nucléaire américain Thresher. Il a laissé une signature : le sous-marin compagnon qui croisait dans son voisinage en surface, l’U.S.S. Skylark, était dans une « zone éclaboussée » par l’interférence scalaire sous-marine. C’est-à-dire qu’un bruit EM parasite a été généré dans tous les systèmes électriques du Skylark, dont certains ont été en fait mis hors service. Le « blocage électronique » était si intense qu’il a fallu plus d’une heure et demi au Skylark pour transmettre un message de secours au quartier général que le Thresher avait un grave problème et que son contact avait été perdu. Certains des systèmes de communications du Skylark était en fait hors d’usage, mais sont redevenus fonctionnels plus tard de manière inexplicable, une fois que le blocage avait disparu. Ce type de « blocage » de bandes multiples et d’équipements électroniques multiples, tout comme le fonctionnement anormal de l’équipement électronique et son rétablissement mystérieux ultérieur, étaient les signatures directes de l’interférométrie scalaire contre la cible sous-marine dans le voisinage du Skylark. Le jour suivant, le 11 avril 1963, le même système d’obusier EM scalaire soviétique a été testé dans le mode pulsé « destruction de sous-marin ». Une énorme détonation EM sous-marine a eu lieu au large de la côte de Porto Rico, à environ 160 kilomètres au nord de l’île, l’explosion sous-marine a provoqué un énorme bouillonnement de la surface de l’océan, suivi par l’élévation d’un champignon géant d’eau d’environ quatre cent mètres de hauteur, le champignon d’eau est ensuite retombé dans l’océan, achevant la signature.

Par chance tout l’incident a été observé par l’équipage effrayé d’un jet de ligne américain qui était en train d’effectuer son contrôle de position dans ce secteur. (Voir J. Durant, “An underwater explosion – or what?”, Pursuit, 5(2), Avril 1972, p. 30-31.)

Ces deux incidents étaient des tests opérationnels en mode réel des superarmes nouvellement déployées de Khrouchtchev, il a probablement organisé ce coup de poing spectaculaire dans un effort désespéré de retrouver un prestige devant le parti communiste après sa désastreuse déconvenue face à Kennedy dans la crise des missiles cubains quelques mois auparavant seulement. Apparemment la tentative fut couronnée de succès, puisqu’il est resté au pouvoir encore un an avant d’en être écarté.

Nuage en forme de champignon au large du Japon près de la zone de test Russe

Ce qui suit concerne « l’explosion froide » du 9 avril 1984. Le site de l’explosion était seulement à environ 320 kilomètres du centre ville de Tokyo, il a été vu par les équipages de plusieurs avions de ligne, dont le vol 36 de la Japan Air Lines.

Peu de temps auparavant les Soviétiques avaient annoncé à la hâte que des essais de missiles seraient menés dans une zone peu distante de l’ancien site d’explosion. Cela a pu être une tromperie pour couvrir cet incident, n’importe quelle nation dirait qu’elle savait ce qui était en train de se passer.

C’était également un « stimulus » direct aux Japonais et au reste du monde. C’est-à-dire stimuler le système et voir si les scientifiques reconnaissent ce qui s’est passé. Si c’est le cas, alors ils connaissent les armes scalaires. Si ce n’est pas le cas, alors ces pays ne savent rien des armes EM scalaires, et ces pays sont sans défenses contre eux. Quoi qu’il en soit, vers 5 heures 14 minutes, temps standard du pacifique, le 9 avril 1984, un nuage géant en forme de champignon a surgit au dessus de l’océan au sud des îles Kuril. Le champignon s’est élevé rapidement, montant à une altitude de 18000 mètres et atteignant un diamètre de 320 kilomètres en 2 minutes. Un pilote de Boeing 747 qui a observé le nuage, était un ancien pilote de bombardier B-52. Il a décrit le nuage comme étant très similaire à celui d’une gigantesque explosion nucléaire, excepté qu’il n’y avait aucun flash de lumière visible. Optant pour une action d’évasion, il a dévié sa trajectoire pour s’éloigner de l’explosion, et il s’est préparé à encaisser le choc de la détonation qui n’est jamais venu...

Un nuage en forme de champignon s’élevant de la mer (explosion froide)

En effet, ce nuage fortement anormal était dû à une explosion froide – un test d’un obusier EM scalaire soviétique en mode endothermique pulsé. Ainsi un test et un beau « stimulus » ont été mené : seuls quelques avions de lignes ont été «alarmés», fournissant un stimulus de haut-niveau aux observateurs compétents. Il était certain que les informations soient rapportés de cette manière à différentes nations, il était certain que la presse s’empare de l’histoire, c’était un stimulus de niveau élevé pour voir si les Etats Unis, le Japon, ou d’autres adversaires potentiels de l’Union Soviétique reconnaissaient l’essai d’une arme à explosion froide. Par notre réaction nous les avons assurés (avec un indice de confiance élevé) que nous ne savions encore rien de l’interférométrie EM scalaire ou des explosions froides. Cinq Boeing 747 en route pour Anchorage en Alaska, ont volé au travers et à proximité du nuage, les avions ont été contrôlés à Anchorage pour la contamination radioactive, mais rien n’a été trouvé, cela démontrait que l’énorme explosion était non-nucléaire. La profondeur de l’océan dans cette zone est d’environ 6300 mètres, c’est en fait trop profond pour qu’un volcan sous-marin ait explosé et provoqué le nuage. (En plus un volcan aurait continué à renifler au moins un peu, ce qui élimine cette explication de l’incident.) Bref, un phénomène fabriqué par l’homme a tout lieu d’être.

En conséquence, nous savons que c’était une explosion froide, en fait, l’effet de base a été reproduit en laboratoire sur une bassine d’eau, en utilisant un petit interféromètre scalaire dans le mode endothermique. Mais l’histoire ne s’est pas arrêtée là.

Un géophysicien de l’université d’Hawaï, le Dr Daniel A. Walker, avec ses collègues, contrôlait un ensemble d’hydrophones sur le fond de l’océan, enregistrant les signaux tels que évènements sismiques, éruptions de volcan, etc.

Le Docteur Walker et ses collègues ont effectué une analyse complète des données enregistrées par les hydrophones durant et aux alentours du moment de l’incident en question, les données montrent l’absence d’un quelconque séisme naturel ou évènement volcanique qui aurait pu provoquer le phénomène du 9 avril au large des côtes du Japon. Lui et ses collègues ont conclu que c’était soit un phénomène naturel inconnu, soit un phénomène d’origine humaine. Leur rapport est publié dans « Science ». (Dr Walker, « Kaitoku Seamount and the Mystery Cloud of 9 April 1984,” Science, 227 (4687), Feb. 8, 1985, p. 607-611.)

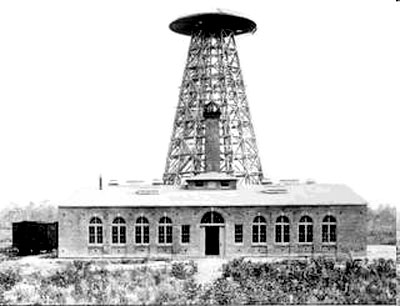

Le bouclier Tesla

L’obus hémisphérique d’énergie qui, il y a quelques années a été surnommé le « Bouclier Tesla », présente un intérêt particulier.

Deux surfaces hémisphériques scalaires sont créées en utilisant des émetteurs à fréquences multiples et des expansions de séries de Fourier tronquées. L’interférence des deux hémisphères scalaires crée un grand obus hémisphérique lumineux d’énergie électromagnétique ordinaire, dans l’obus la densité d’énergie est suffisante pour soulever le problème de Dirac de la mer de vide de Dirac, l’obus est ainsi rempli d’un plasma rayonnant.

Une telle coquille peut avoir plusieurs centaines de kilomètres de diamètre à la base. L’énorme énergie nécessaire pour former un tel bouclier de défense est obtenue par une « vanne d’énergie scalaire » dans le noyau en fusion de la Terre elle même comme cela a été expliqué précédemment. Fin avril début mai 1985, 27 de ces « vannes d’énergies » ont été placées dans la Terre par les Soviétiques, si chaque vanne est capable d’actionner 4 à 6 grandes armes EM scalaires, alors l’arsenal stratégique EM scalaire soviétique contient plus de 100 monstrueuses superarmes capables de produire des explosions exothermiques, des explosions endothermiques, de manipuler le climat, de localiser et détruire des sous-marins en plongée, de détecter et détruire des missiles balistiques très rapidement après le décollage, de détecter et détruire des bombardiers stratégiques à long rayons d’action aussitôt qu’ils sont en vol, etc.

En tous cas, le bouclier géant de Tesla est utile contre n’importe quel véhicule essayant de pénétrer, si l’obus n’est pas si grand, sa densité d’énergie peut être très haute, dans ce cas, le chauffage intense du plasma fusionnera et vaporisera même des corps métalliques. De plus, n’importe quel véhicule rencontrant la coquille est soumis à un effet EMP extrêmement intense se générant partout à l’intérieur de ses circuits. Un blindage EMP est inefficace contre la création d’énergie à travers l’espace-temps de ses circuits ; un tel blindage protégera seulement contre un flux d’énergie circulant dans l’espace d’une manière conventionnelle.

Donc l’électronique de n’importe quel véhicule rencontrant le bouclier est instantanément dégradé, qu’il soit ou non blindé contre les interférences électromagnétiques ordinaires (EMI). Cela inclut les systèmes électroniques des ogives nucléaires portées par un véhicule de rentrée, électriquement tout ce qui ce qui pénètre la coquille est totalement dégradé , ensuite les matériaux explosifs sautent quand un tel effet EMP est rencontré, et les matériaux combustibles se consument rapidement ou sont mis à feu. La protection d’ablatif subit une catastrophe intéressante, puisque l’énergie n’essaye pas de s’immiscer dans la protection mais y surgit partout simultanément, l’ablation a lieu partout à l’intérieur du matériau ablatif et le fait simplement exploser instantanément. De plus, pour les boucliers Tesla plus petits (disons de 80 kilomètres de diamètre) la densité d’énergie est suffisante pour fondre ou vaporiser les métaux tels que les structures de missiles.

Avec un tel bouclier Tesla, il n’y a aucun besoin de distinguer les véhicules de rentrée portant de vraies ogives des leurres, balles, etc. Tout le « désordre » entrant dans le bouclier est simplement « nettoyé » et « stérilisé » ou détruit. Le bouclier peut s’occuper des ICBM/IRBM et leurs têtes nucléaires, des bombardiers stratégiques et leurs bombes nucléaires, des véhicules de rentrées et leurs ogives, des leurres, des balles, etc.

Direction Saryshagan – septembre 1979

Le journal “London Sunday Times” du 17 août 1980 contenait une information et une photo-croquis d’incidents dénotant les essais de très grands globes Tesla bien à l’intérieur de l’Union Soviétique, les observations ont été faites en Afghanistan par Nick Downie un caméraman de guerre britannique. Les phénomènes aperçus étaient dans la direction de la zone d’essais de missile de Saryshagan qui -- selon le Département de la Défense Américaine « la puissance militaire soviétique », 1986 – contient une ou plusieurs grandes armes à énergie dirigée (DEW).

Bien que Downie voyait le globe de lumière depuis une grande distance, il s’est enflammé silencieusement sur l’Hindu Kush et s’est élargi jusqu’à sous-tendre un arc d’environ 20 degrés, s’atténuant au fur et à mesure de son extension. (Un arc de 20 degrés sous-tendu par un objet distant de plusieurs centaines de kilomètres indique un diamètre d’objet bien supérieur à 100 kilomètres, cela donne une certaine idée des énergies énormes qui sont contrôlées et manipulées par ces armes soviétiques.) Downie a vu le phénomène en plusieurs occasions en septembre 1979.

En décembre 1979, un globe lumineux stationnaire contenant une raie noire verticale au centre a été vu dans le ciel de la côte de St. Petersburg en Floride, ce type particulier d’observation dans cette zone a été auparavant relié avec les périodes d’activités connues à Saryshagan. Plus tard, dans le même mois, les satellites américains Vela d’alerte nucléaire ont détecté un « flash nucléaire » sur l’Atlantique sud, au large de la côte d’Afrique. La controverse a fait rage jusqu’à nos jours dans les services de renseignements américains et dans les cercles scientifiques, à savoir si c’était une explosion nucléaire ou une autre sorte de mécanisme qui a produit le flash. En effet, le flash peut avoir été produit par un obusier EM scalaire depuis Saryshagan comme une « sonnette » de plus envers le système des services de renseignements américains, pour vérifier s’ils connaissaient quelque chose ou non à propos des obusiers EM scalaires, de nouveau la réponse négative leur a dit avec un grand indice de confiance que (1) Nous ne connaissions pas encore les « trucs » EM scalaires, et (2) Nous étions toujours totalement sans défense contre l’armement EM scalaire soviétique. En tous cas, selon les observations de Downie, il est fortement probable que l’armement DEW de la zone d’essais de missiles de Saryshagan était actif en septembre 1979, et qu’il produisait les grands globes Tesla, si les DEW à Saryshagan peuvent produire les immenses globes Tesla lumineux, ce sont presque certainement des interféromètres EM scalaires et peuvent alors également produire les boucliers Tesla géants. Downie a rapporté d’autres observations de phénomènes similaires, faites précédemment par les Afghans, au loin à l’intérieur de l’Union soviétique dans la même direction vers Saryshagan...

Brièvement, abordons les utilisations d’un tel globe géant ou d’une coquille sphérique d’énergie EM et de plasma lumineux. En plaçant un tel globe géant à des centaines de kilomètres de distance du centre défendu, un arc entier du ciel peut être défendu contre l’attaque de missiles balistiques à longues portées, en plein milieu de leurs trajectoires, les missiles attaquants devront pénétrer deux fois la coquille globulaire, s’exposant deux fois aux puissants effets EMP internes. Il existe donc une très forte probabilité que tous les missiles traversant l’espace occupé par le globe sont mis hors service à l’entrée et/ou à la sortie, cela inclut les systèmes électroniques dans les ogives nucléaires elle-mêmes. Cela est donc particulièrement efficace contre les porteurs de missiles MIR V et MAR V puisque les multiples véhicules de rentrée sont normalement encore sur le véhicule principal durant la plus grande partie de la course, l’utilisation de ce globe de défense d’ABM en pleine course réduit fortement le nombre de véhicules arrivant à la dernière partie de leurs courses et à la phase terminale de leurs trajectoires. En utilisant un globe plus petit et plus intense, et en le plaçant à l’encontre d’objets isolés ou de groupes d’objets entrants, l’effet EMP et l’échauffement local agissent contre ces objets, cela est approprié dans la dernière partie de leurs courses et dans la phase terminale des ICBM, IRBM, SLBM et missiles de croisières. Il est également utile contre les bombardiers stratégiques entrants et leurs missiles air-sol balistiques ou de croisières. Deux modes peuvent être utilisés pour les globes – spécialement pour les petits – en premier le mode continu peut être utilisé pour « frire » ou vaporiser les objets entrants dans un volume relativement petit (disons 15 à 25 kilomètres de diamètre). En second, le mode « pulsé » peut être utilisé pour « assurer » tous les objets entrants, qu’ils aient ou non traversé la défense de pleine course « grand globe », cela fournit une garantie complémentaire de tuer les objets ; la discrimination n’est pas nécessaire, simplement de tous les avoir. L’exposition de tous les objets entrants aux attaques multiples élève la probabilité de destruction à quasiment 100%, ou bien d’être proche de ce que l’on souhaite, bien sûr le véhicule arrivant peut encore rencontrer une défense terminale consistant en un bouclier Tesla associé à des petits globes intenses mobiles à déploiement rapide.